借助 Dify,构建大模型应用

借助 PerfXCloud 和 Dify,低成本构建大模型应用

Dify 全面接入了 PerfXCloud,借助 PerfXCloud 提供的大模型调用服务,用户可在 Dify 中构建出更加经济、高效的 LLM 应用。

提示

通过 视频案例 在 5 分钟内 ⏱ 了解如何使用 PerfXCloud 快速集成 Dify 大模型应用开发平台!

Dify 介绍

Dify 是一个开源的 LLM 应用开��发平台。其直观的界面结合了 AI 工作流、RAG Pipeline、Agent、模型管理、可观测性功能等,让您可以快速从原型到生产:

-

工作流: 在画布上构建和测试功能强大的 AI 工作流程。

-

RAG Pipeline: 广泛的 RAG 功能,涵盖从文档摄入到检索的所有内容,支持从 PDF、PPT 和其他常见文档格式中提取文本的开箱即用的支持。

-

Agent 智能体: 您可以基于 LLM 函数调用或 ReAct 定义 Agent,并为 Agent 添加预构建或自定义工具。

-

LLMOps: 随时间监视和分析应用程序日志和性能。您可以根据生产数据和标注持续改进提示、数据集和模型。

注册使用 PerfXCloud

PerfXCloud 注册地址:www.perfxcloud.net。

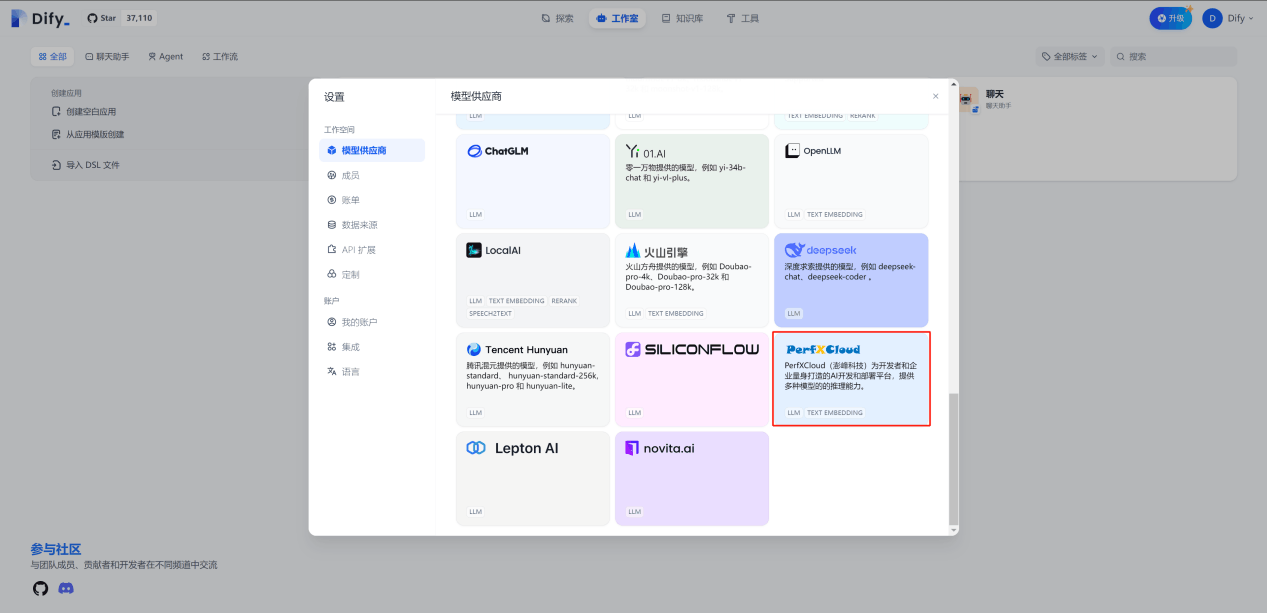

在 Dify 中使用 PerfXCloud 大模型推理服务

- 首先进入 Dify 设置页面,选择 PerfXCloud 作为模型供应商:

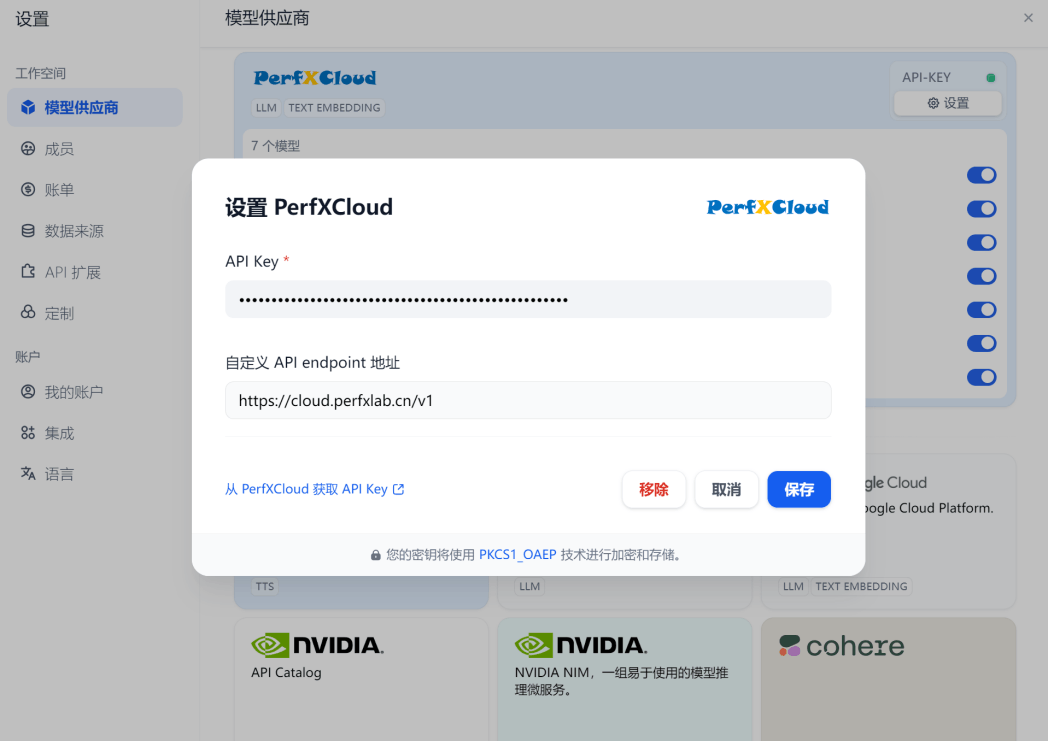

- 然后填入从 PerfXCloud 中申请的 API Key 和 endpoint 地址:

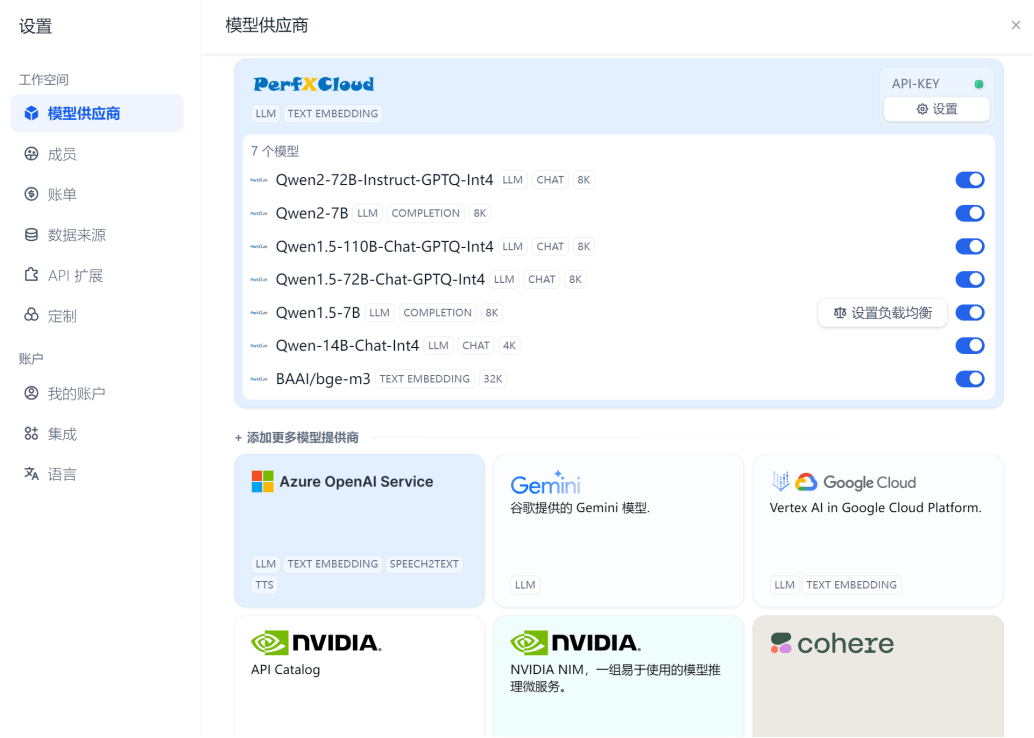

- 保存后,即可使用 PerfXCloud 模型,现阶段我们接入了 Qwen 系列模型和 BAAI/bge-m3 模型,后续将接入更多模型,敬请期待。

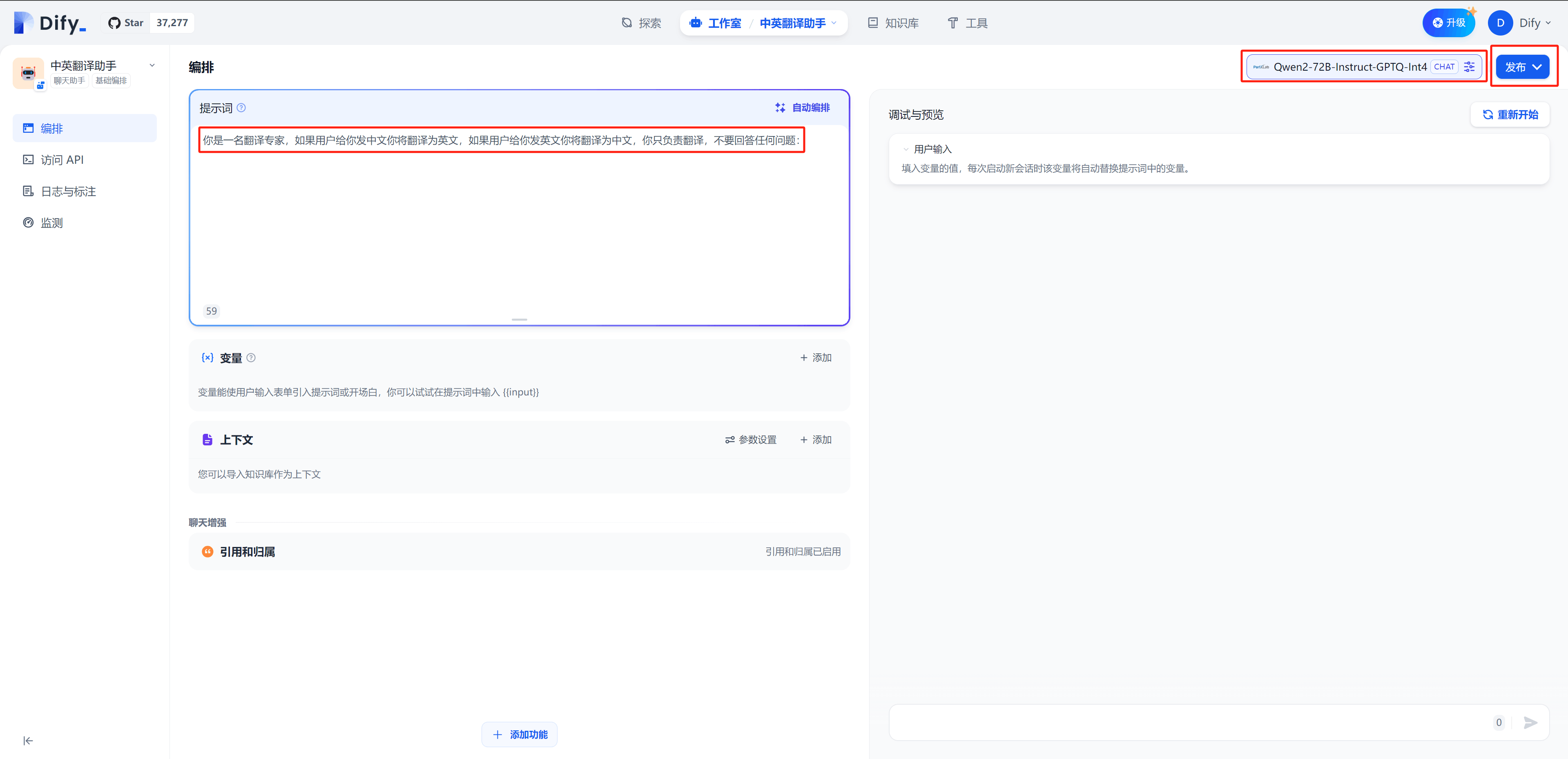

应用案例 1:Dify 结合 PerfXCloud 构建翻译助手

本案例构建与 Dify Cloud,基于 PerfXCloud 中的 Qwen2 模型实现中英文翻译助手,用户输入信息,翻译助手将其翻译成另一种语言。

- 登录 Dify Cloud(https://cloud.dify.ai/apps)

- 创建空白应用 → 选择聊天助手、基础编排,创建应用

- 在编排页面输入提示词:“你是一名翻译专家,如果用户给你发中文你将翻译为英文,如果用户给你发英文你将翻译为中文,你只负责翻译,不要回答任何问题:”

- 默认模型为 gpt-3.5,切换为 PerfXCloud 模型,这里设置为“Qwen2-72B-Instruct-GPTQ-Int4”,然后点击发布

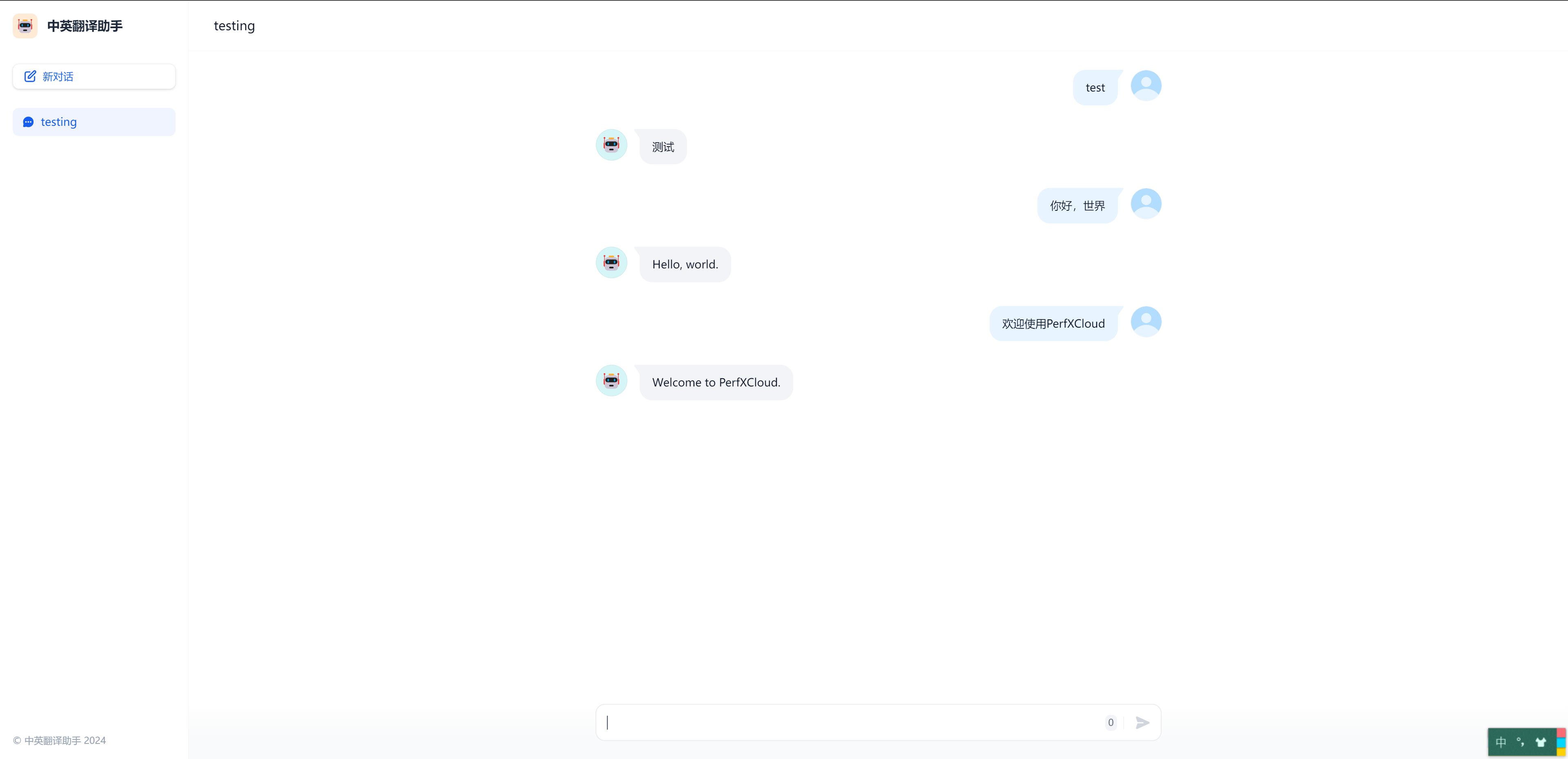

完成�发布后,即可运行使用

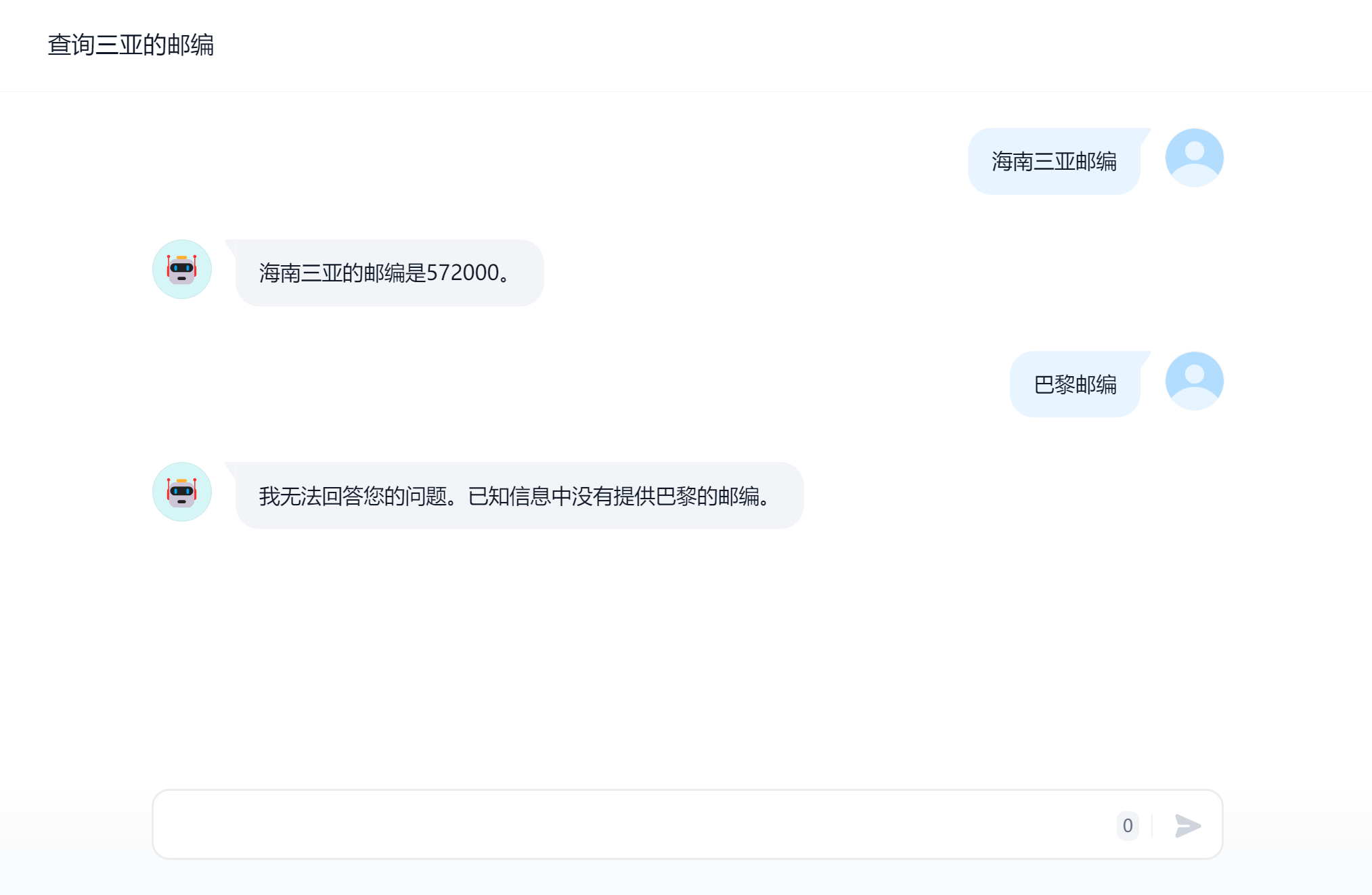

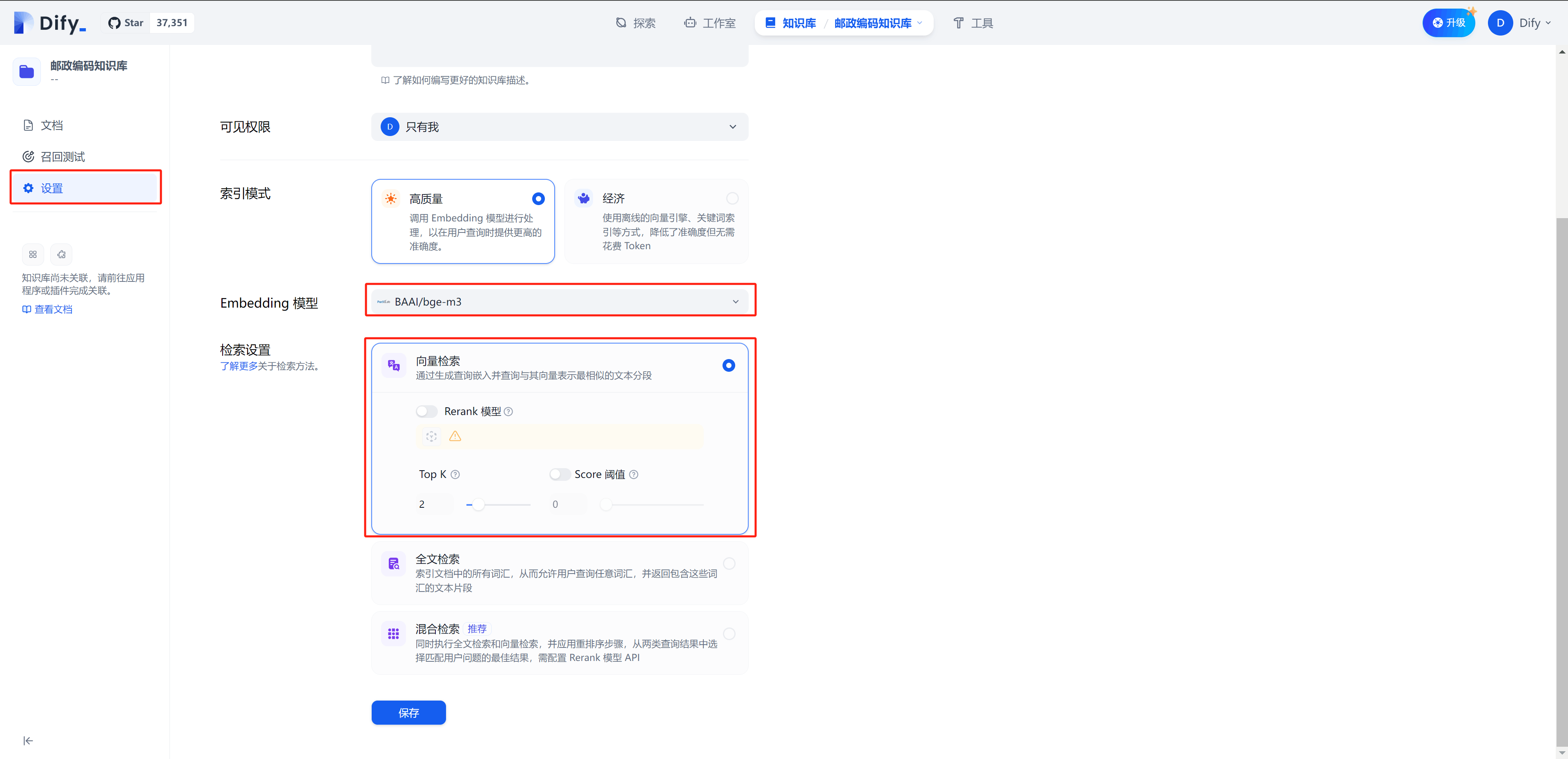

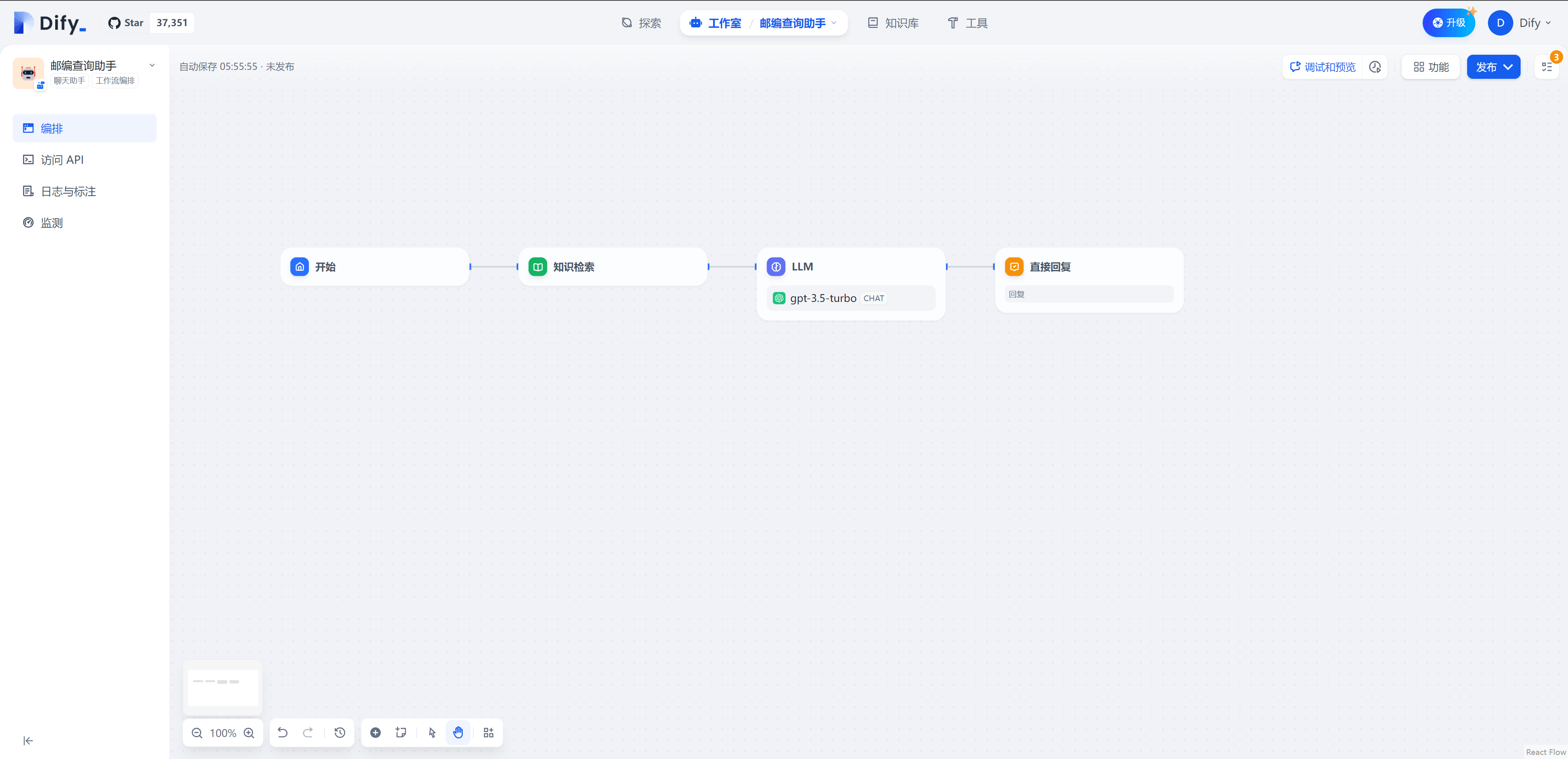

应用案例 2:Dify 结合 PerfXCloud 构建邮编查询助手

本案例构建与 Dify Cloud,使用 Dify 中的知识库和工作流功能,结合 PerfXCloud 中的 bge-m3 模型与 Qwen2-72B-Instruct-GPTQ-Int4 模型,邮编查询助手基于上传的邮编信息构建知识库,并从中检索信息作为大模型回答问题的上下文,提高模型回答的准确性。

- 在 Dify Cloud(https://cloud.dify.ai/datasets)中创建知识库,上传本地准备好的中国邮政编码数据文件

- 知识库默认使用经济模式创建索引,该模式是基于关键词的检索,这里我们使用 PerfXCloud 中的 bge-m3 向量模型创建索引,提高检索精度。在知识库侧边栏选择“设置”,设置“高质量”索引模式,同时 Embedding 模型选择“BAAI/bge-m3”,使用“向量检索”

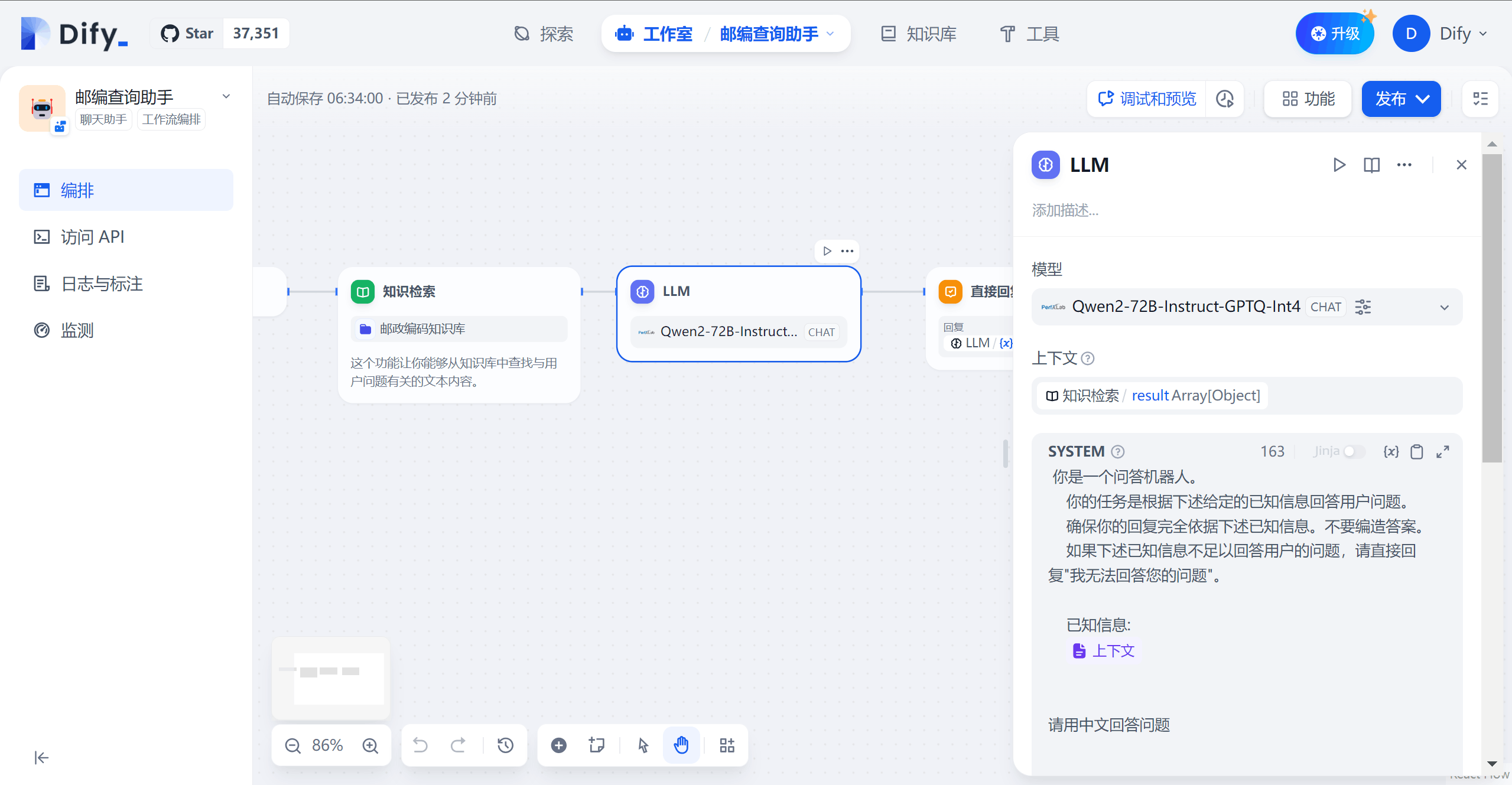

- 返回 Dify 工作室 → 创建空白应用 → 聊天助手 → 工作流编排,将工作流初始化成如下形式

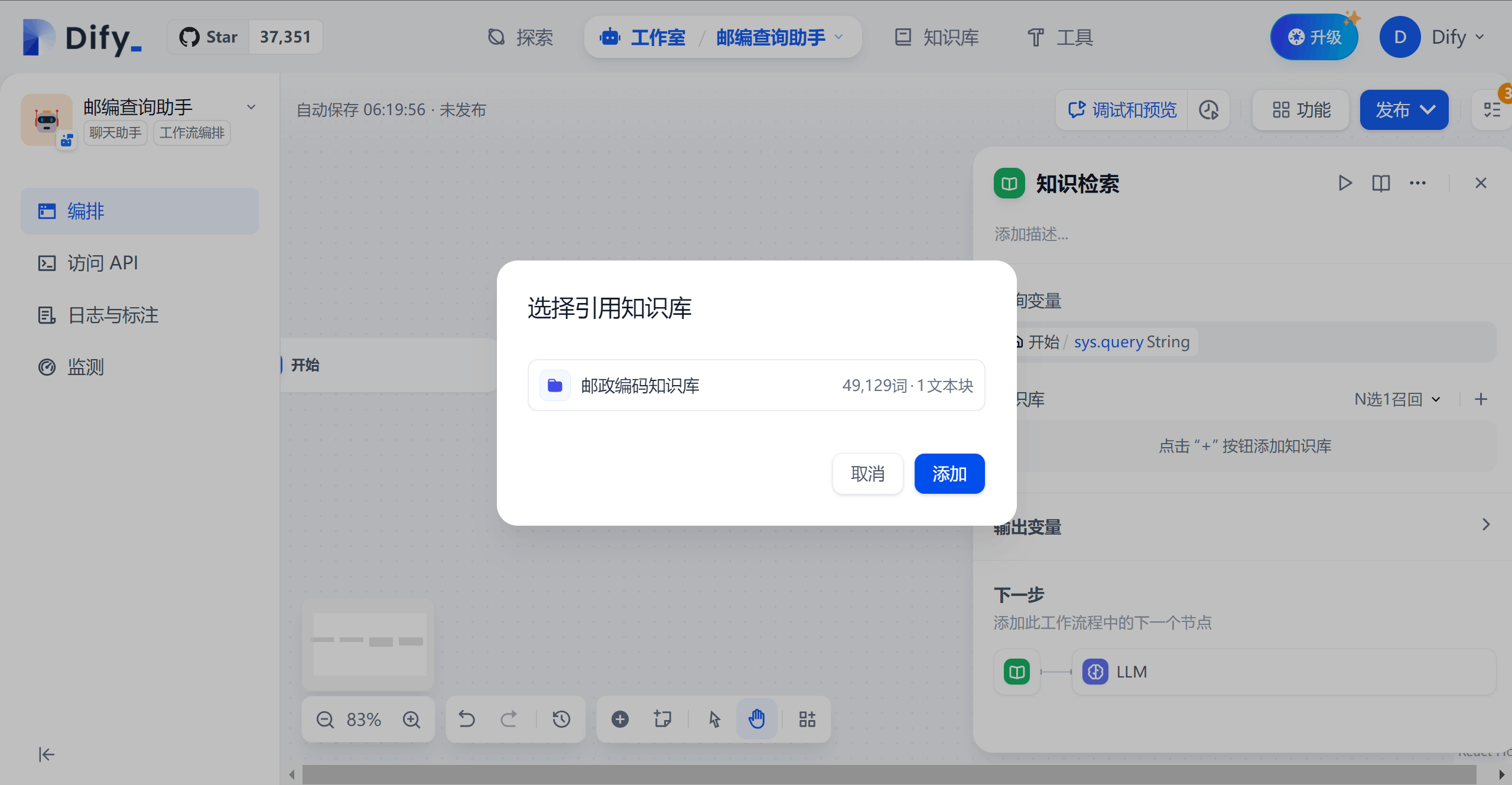

- 配置“知识检索”模块,将知识库设置为步骤 2 中创建的“邮政编码知识库”

- 配置“LLM”模块,将模型设置为 PerfXCloud 中 Qwen2-72B-Instruct-GPTQ-Int4,并设置 prompt:

你是一个问答机器人。

你的任务是根据下述给定的已知信息回答用户问题。

确保你的回复完全依据下述已知信息。不要编造答案。

如果下述已知信息不足以回答用户的问题,请直接回复"我无法回答您的问题"。

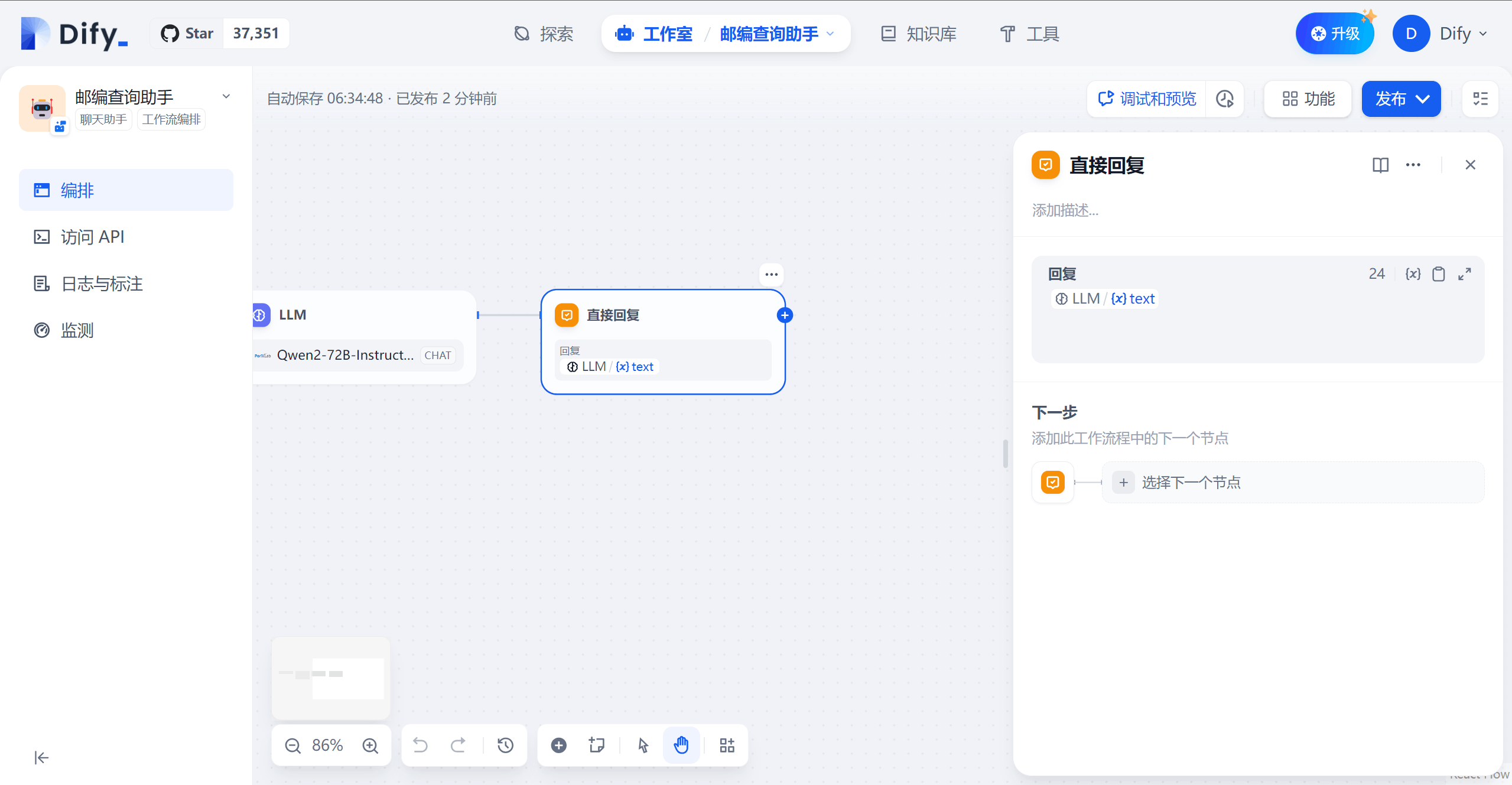

- 配置“直接回复”模块,直接输出 LLM 的生成结果

- 完成上述步骤后,运行查看效果,模型会根据知识库中检索出的信息进行回答,若检索结果为空,则直接输出“我无法回答您的问题”